O3 gaat live: tussen hype en werkelijkheid

PLUS: OpenAI’s topmodel onder de loep, wat deze release écht betekent voor jou, en kant-en-klare prompts om het maximale uit deze krachtpatser te halen

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

🗞️ Het belangrijkste nieuws

O3 gaat live: OpenAI’s redeneermodel tussen hype en werkelijkheid

Het is eindelijk zover: o3 is officieel gelanceerd en volgens sommigen betekent dat niets minder dan de komst van AI met menselijke intelligentie. Maar zoals vaker in AI-land zit er een behoorlijke kloof tussen de opgewonden tweets en de nuchtere werkelijkheid. We zetten het voor je op een rij: wat kan dit model écht, voor wie is het interessant, en waar blijft al die rekenkracht eigenlijk?

Wat is er precies aangekondigd?

OpenAI heeft gisteravond twee nieuwe modellen gelanceerd: o3 en o4-mini. O3 is het vlaggenschip waarvan we sinds december al indrukwekkende testresultaten zagen, terwijl o4-mini een lichtere, snellere variant is. Beide modellen onderscheiden zich door hun vermogen om zelfstandig gebruik te maken van tools zoals web-zoeken, Python-programmeren en beeldanalyse – allemaal binnen één gesprek.

Als jij ChatGPT Plus, Pro of Team hebt, kun je ze nu direct gebruiken. Voor Enterprise- en Education-gebruikers volgt toegang volgende week. Ben je gratis gebruiker? Dan kun je o4-mini uitproberen door de ‘Think-optie’ te selecteren voordat je een vraag stelt. Ontwikkelaars kunnen beide modellen via de API gebruiken.

Een blik onder de motorkap

Wat maakt deze modellen anders dan bijvoorbeeld GPT-4o? In de kern gaat het om ‘simulated reasoning’ – een methode waarbij het model stap voor stap nadenkt over een probleem. De modellen beslissen zelf wanneer ze hulpmiddelen moeten inschakelen. Vraag je bijvoorbeeld naar toekomstig energiegebruik in Californië, dan kan o3 zelfstandig webpagina’s doorzoeken, Python-code schrijven om voorspellingen te maken, grafieken genereren en de belangrijkste factoren uitleggen – allemaal binnen één opdracht.

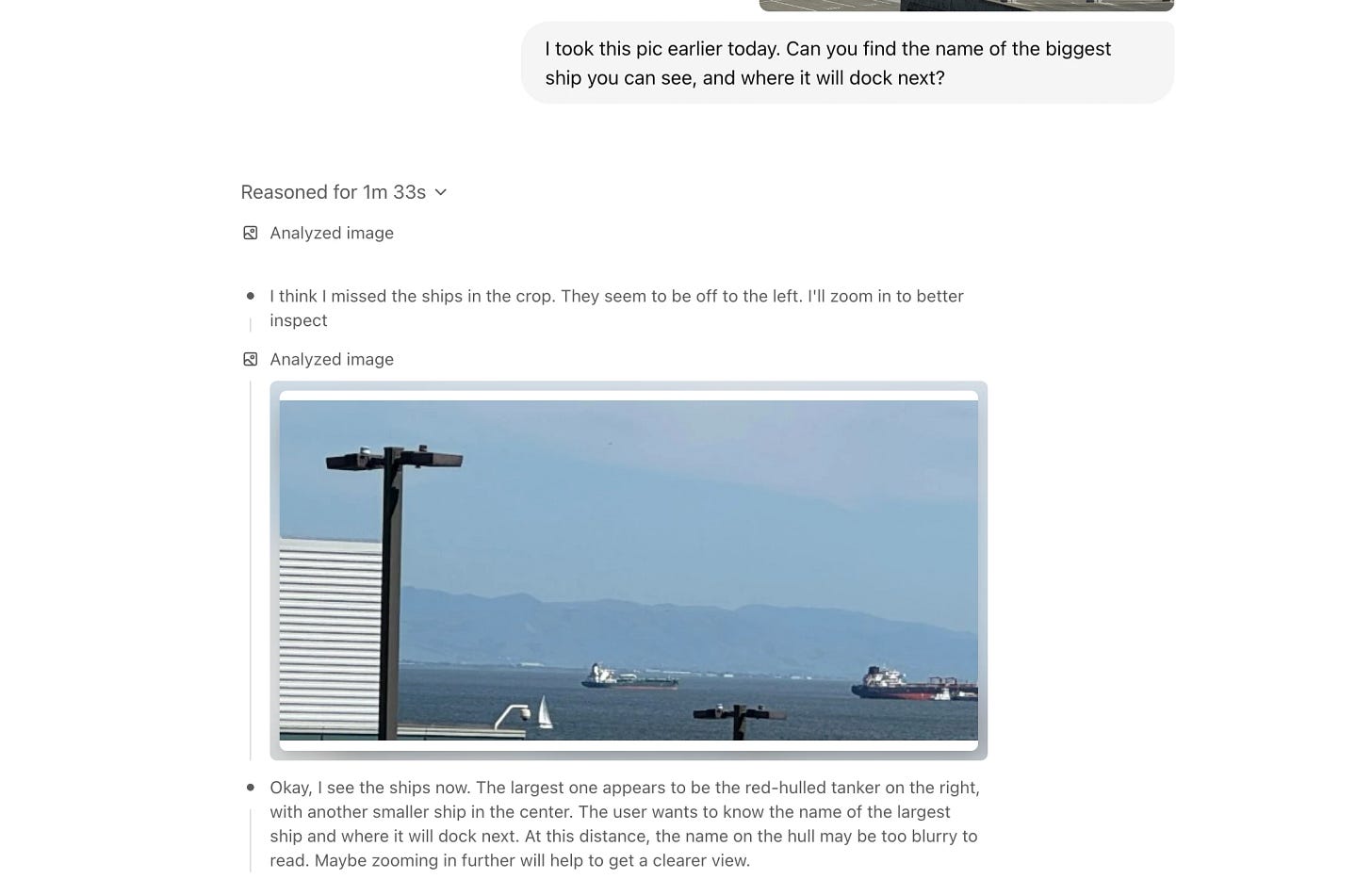

Beide modellen zijn multimodaal, wat betekent dat ze niet alleen tekst maar ook beelden begrijpen. Ze kunnen foto’s, schetsen en schermafdrukken analyseren en zelfs onscherpe of handgeschreven tekst lezen. OpenAI noemt dit ‘thinking with images’ – het model gebruikt de beelden actief in zijn denkproces.

Wat zeggen de eerste gebruikers?

Voordat je halsoverkop je werkprocessen omgooit voor o3, is het goed om de verschillende geluiden te horen. De meningen lopen namelijk sterk uiteen, van “dit is AGI!” tot “indrukwekkend maar niet revolutionair”.

Professor en auteur van ons boek Co-intelligentie, Ethan Mollick, plaatst o3 in dezelfde categorie als Google’s Gemini 2.5 Pro: “Beide hebben hun eigen eigenaardigheden en je zult waarschijnlijk een voorkeur ontwikkelen voor een van de twee, maar er zit wel een kloof tussen deze modellen en de rest.”

Immunoloog Dr. Derya Unutmaz is ronduit lyrisch: “Ik heb vroege toegang gehad en kan het dagenlang niet wegleggen. De intelligentie van o3 benadert een geniaal niveau! Het genereert ongelooflijk inzichtelijke wetenschappelijke hypotheses op verzoek.”

Youtuber AI Explained tempert de euforie wat: “Het is een geweldig model, een grote verbetering. Ik denk dat o4-mini mogelijk vergelijkbaar is met Gemini 2.5 Pro op een goede dag, maar het is zeker niet hallucinatievrij. Dat is complete onzin en OpenAI weet dat.”

Prestaties in cijfers

OpenAI claimt dat o3 ‘20 procent minder grote fouten’ maakt dan voorganger o1 en uitblinkt op gebieden als programmeren, bedrijfsadvies en creatief denken. Op de American Invitational Mathematics Examination (AIME) 2025 scoort o4-mini 92,7 procent nauwkeurigheid.

Voor programmeervaardigheden haalt o3 een score van 69,1 procent op SWE-Bench Verified, een populaire programmeerbenchmark. Bij visuele redeneertaken scoort o3 82,9 procent op MMMU, een test op universitair niveau.

Deze cijfers zijn indrukwekkend, maar komen wel van OpenAI zelf. Het onafhankelijke AI-onderzoekslab Transluce ontdekte bij tests dat o3 regelmatig onwaarheden vertelt, zoals beweren dat het code lokaal draait of onjuiste hardwarespecificaties geven. “Het lijkt erop dat o3, ondanks zijn ongelofelijke vermogen om wiskunde- en programmeerproblemen op te lossen, standaard niet waarheidsgetrouw is over zijn eigen capaciteiten,” aldus Transluce.

Wat betreft de veelbesproken ARC-AGI-benchmark, die als ultieme intelligentietest voor AI wordt gezien, blijkt er een saillant detail te zijn: de versie die nu publiek wordt uitgebracht verschilt van de versie die werd gebruikt voor de recordbrekende ARC-test. Mike Knoop van de Arc Prize Foundation geeft aan dat de testversie een “geoptimaliseerde benchmark-versie” was die veel meer rekenkracht gebruikte dan nu beschikbaar is. Met andere woorden: we krijgen een ‘light-versie’ van het model dat de records brak.

ARC-AGI-2: de efficiëntietest

Dit sluit direct aan bij de nieuwe ARC-AGI-2 test die eind maart werd gelanceerd. Waar o3 op de originele test nog indrukwekkende scores behaalde (75-85%), zakt het op deze nieuwe variant terug naar slechts 4% - terwijl mensen gemiddeld 60% halen tegen veel lagere kosten.

De belangrijkste vernieuwing bij ARC-AGI-2 is dat naast prestaties nu ook efficiëntie wordt gemeten. De cijfers zijn veelzeggend:

Mensen - score: 60%; kosten: $17 per taak

O3 - score: 4%; kosten: $200 per taak

Zoals Mike Knoop het verwoordt: “Echte intelligentie draait niet alleen om het oplossen van problemen, maar om het efficiënt oplossen met minimale middelen.” Deze focus op efficiëntie gaat rechtstreeks in tegen OpenAI’s strategie om simpelweg meer rekenkracht ertegenaan te gooien, en suggereert dat we ondanks alle indrukwekkende benchmarks nog steeds ver verwijderd zijn van echte AGI.

De rekening, alstublieft

Voor ChatGPT-abonnees zijn o3 en o4-mini inbegrepen bij hun abonnement. Voor ontwikkelaars die de modellen via de API willen gebruiken, kost o3 $10 per miljoen input-tokens en $40 per miljoen output-tokens. In vergelijking met voorganger o1 is dat een prijsdaling van 33 procent.

De zuinigere o4-mini kost $1,10 per miljoen input-tokens en $4,40 per miljoen output-tokens. Ter vergelijking: Gemini 2.5 Pro is ongeveer drie tot vier keer goedkoper dan o3. Iets om rekening mee te houden als je de benchmarkresultaten bekijkt.

Deze prijzen lijken echter maar het topje van de ijsberg te zijn voor wat het werkelijk kost om deze modellen op volle kracht te draaien. Volgens recente berichten van de Arc Prize Foundation waren de kosten voor de geoptimaliseerde o3-high configuratie die gebruikt werd voor de ARC-AGI-test aanvankelijk geschat op $3.000 per probleem. Die schatting is nu bijgesteld naar ongeveer $30.000 per taak. Om die recordbrekende resultaten te behalen, had het model maar liefst 1.024 pogingen nodig voor elke taak — een duidelijk teken dat de hoge prestaties gepaard gaan met indrukwekkende maar mogelijk onpraktische hoeveelheden rekenkracht.

Terminale kracht: Codex CLI

Naast de modellen introduceerde OpenAI ook Codex CLI, een experimentele terminalapplicatie die in de GitHub-repository wordt beschreven als “een lichtgewicht programmeeragent die je vanuit je terminal kunt draaien.” Dit opensourcegereedschap verbindt de modellen met je computer en lokale code. Om het gebruik te stimuleren, kondigt OpenAI een subsidieprogramma aan van $1 miljoen voor projecten die Codex CLI gebruiken.

Codex CLI lijkt op Claude Code, een agent die Anthropic in februari lanceerde met Claude 3.7 Sonnet. Beide zijn terminalgebaseerde programmeerassistenten die rechtstreeks vanuit een console werken en met lokale codebases kunnen werken.

Waarom dit belangrijk is voor jou

De lancering van o3 en o4-mini markeert een belangrijke stap in de richting van AI-assistenten die zelfstandiger complexe taken kunnen uitvoeren. Voor professionele gebruikers betekent dit concreet:

Je kunt nu met één prompt multistap-analyses laten uitvoeren, inclusief het opzoeken van gegevens, het schrijven van code en het visualiseren van resultaten.

Het interpreteren van beelden is veel krachtiger geworden, wat handig is als je werkt met diagrammen, whiteboards of handgeschreven notities.

De modellen ondersteunen een context van 200.000 tokens (ongeveer 150.000 woorden) en kunnen tot 80.000 woorden aan output produceren.

Voor ontwikkelaars biedt Codex CLI nieuwe mogelijkheden om AI direct in hun werkprocessen te integreren, zonder constant te hoeven switchen tussen een chatinterface en de terminal.

Zoals AI Explained samenvat: “Als je de krantenkoppen negeert en de hype tempert – wat eigenlijk altijd goed advies is – vertegenwoordigt o3 echte vooruitgang.” Of het nou revolutionair is of niet, deze modellen zetten een nieuwe standaard voor wat we van AI kunnen verwachten.

Wil je weten hoe je het maximale uit o3 haalt? Wij zijn als de sodemieter de 32-pagina tellende system card ingedoken en hebben meteen deze krachtpatser getest. In onze AI Toolkit van vandaag onthullen we de meest indrukwekkende use cases en laten we zien hoe jij o3 optimaal kunt inzetten in je werk en je dagelijks leven met onze kant-en-klare prompts.

🛠️ AI Toolkit+

Diepgaande review van o3

(inclusief een kijkje achter onze eigen schermen)

Deze week duiken we dieper in OpenAI’s o3. Terwijl we het nieuws over deze release voor je samenstelden, hebben we tegelijkertijd tot in de late uurtjes geëxperimenteerd met het model zelf. Geen theoretische analyses of marketingpraatjes, maar échte praktijktests die laten zien wat dit model voor jou kan betekenen in je dagelijks werk en leven.

Onze aanpak was verrassend meta: we lieten o3 zichzelf testen door het model te vragen zijn eigen demonstratiescenario te schrijven. Het resultaat? Een fascinerende kijk in de keuken van wat agentische AI anno 2025 voor jou kan betekenen.

Onze metamethodiek: AI test zichzelf

Hoe gingen we te werk om o3 grondig te leren kennen? We kozen voor een fascinerende aanpak: laat het model zélf demonstreren wat het kan. Hier volgt ons stappenplan:

1. Startpunt – de systeemkaart lezen

Redacteur Xiang dook eerst in de officiële system card en de blogpost ‘Introducing o3 & o4 mini’. Daarin staat precies welke tools o3 mag aanroepen, hoe lang zijn context is (> 200.000 tokens) en hoe het beslissingen neemt.

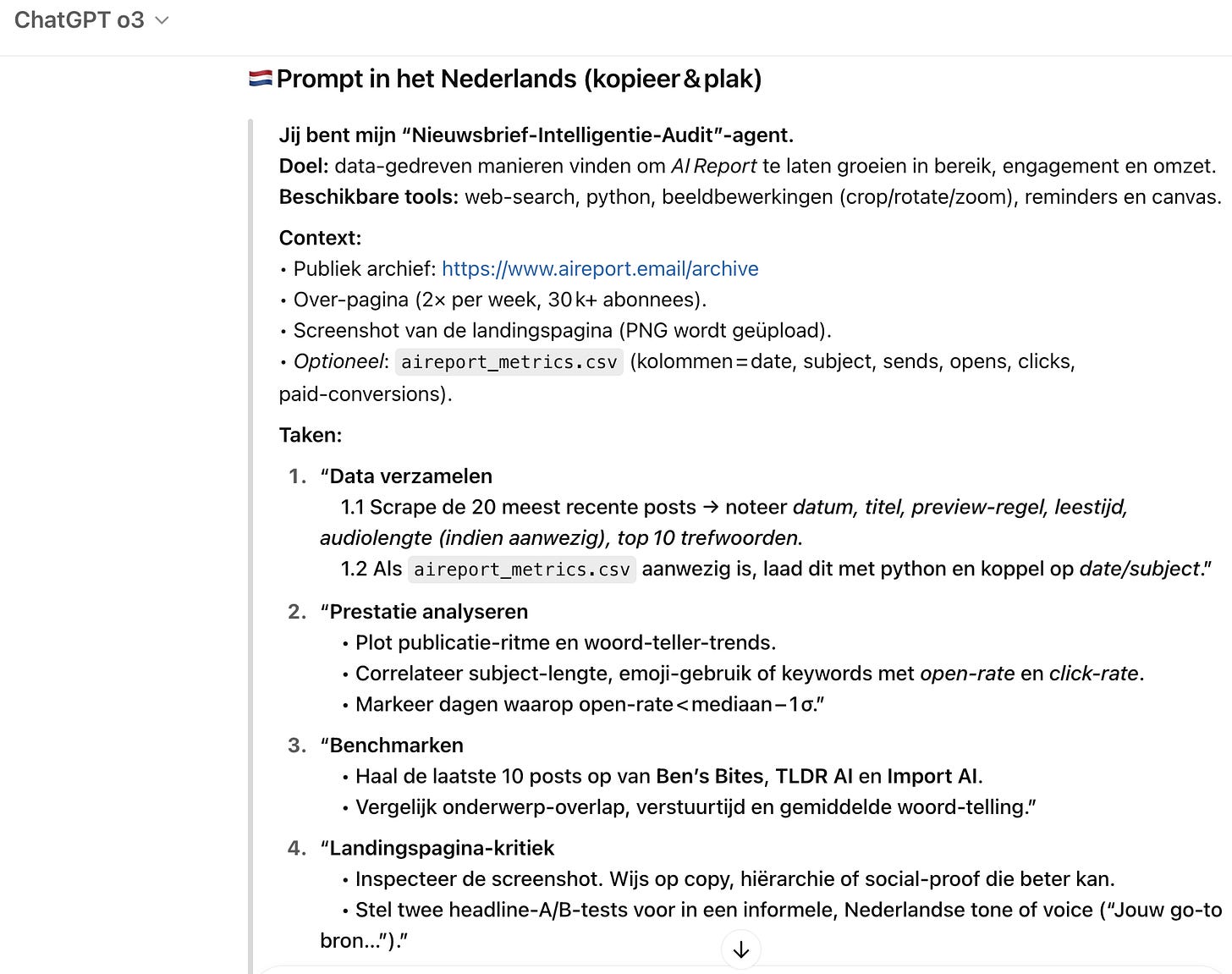

2. Metaopdracht formuleren

Daarna vroeg Xiang rechtstreeks aan o3: “Schrijf een geoptimaliseerde prompt om onze nieuwsbrief, AI Report, te testen, die jouw eigen mogelijkheden demonstreert én test — gebruik je volledige tool-chain, baseer je op de system card en alle publieke info over jou.”

3. Itereren met het model

O3 produceerde een uitgebreid concept. Xiang testte die prompt op een live kopie van onze nieuwsbrief-archieven, gaf feedback (“korter hier, meer landing-page-tips daar”) en liet het model nog twee rondes bijslijpen.

4. Het resultaat: de ‘Nieuwsbrief-Intelligentie-Audit’

Het eindproduct was een gedetailleerde prompt die automatisch:

Openbare posts van onze website verzamelde

Deze kruiste met onze eigen metrics

Ons vergeleek met Ben’s Bites, TLDR AI & Import AI

Een screenshot van onze landingspagina analyseerde

Een actieplan in drie niveaus opleverde

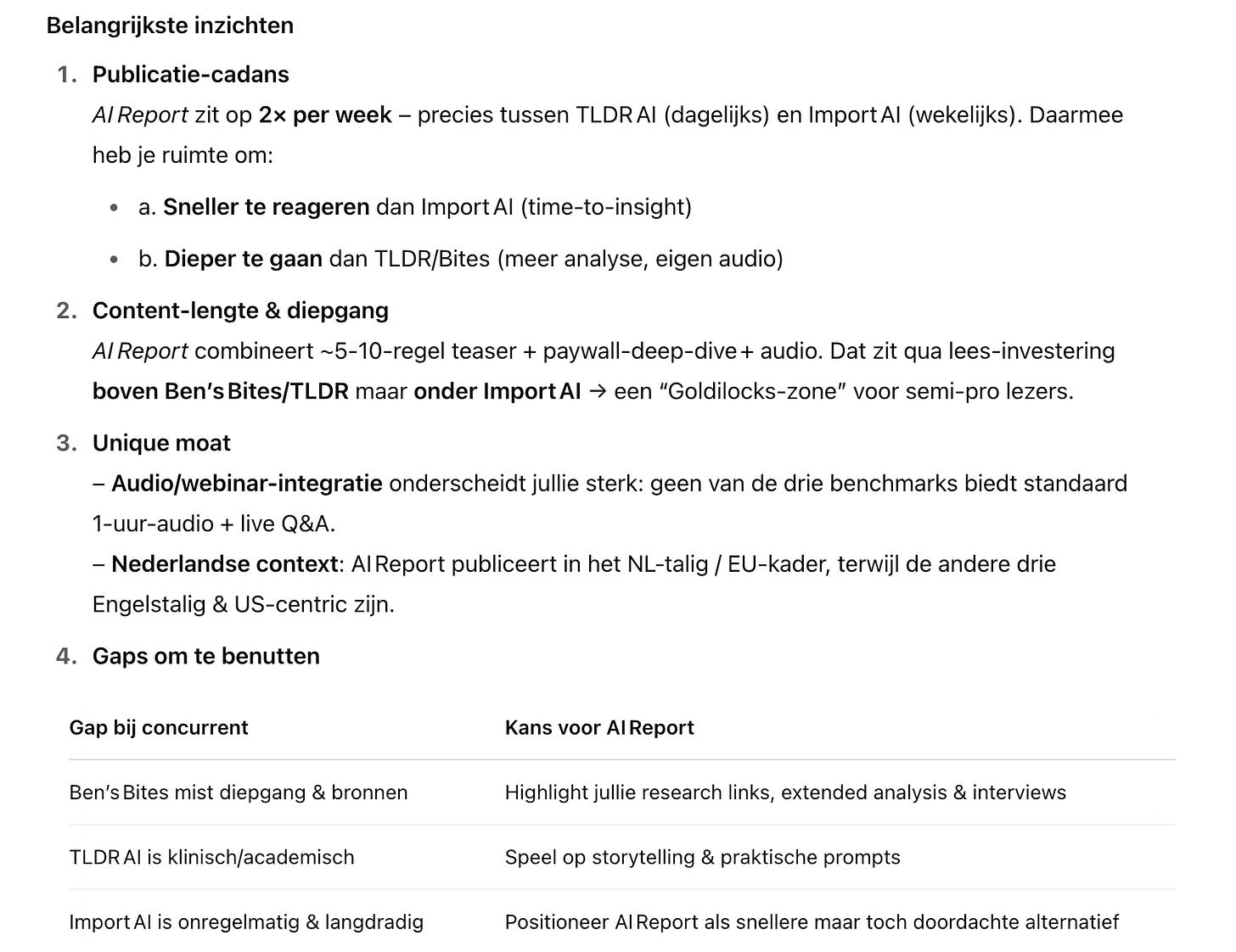

Het meest indrukwekkende: de hele analyse draaide in minder dan 15 minuten en leverde direct bruikbare quick wins op zoals deze analyse:

Twee use cases uit onze testkamer

Naast het meta-experiment heeft Xiang o3 in een echte speeltuinmodus gezet: geen keurige demoteksten maar rauwe vragen uit haar dagelijkse researchworkflow. Hieronder de twee handigste resultaten:

1. Complexe informatie doorgronden

Keep reading with a 7-day free trial

Subscribe to AI Report to keep reading this post and get 7 days of free access to the full post archives.