Nooit meer zelf meeting notes maken

PLUS: de AI-tools die je vergaderingen transformeren, Meta’s nieuwe AI-knop in WhatsApp, en waarom een expert superintelligentie in 2027 voorspelt

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

🗞️ Het belangrijkste nieuws

Chatten met dat blauwe rondje in WhatsApp én Llama 4: Meta’s tweeluik

Zat jij dit weekend ook te appen en ontdekte je opeens een gloeiend paarsblauw rondje in je WhatsApp? Gefeliciteerd, je bent nu officieel onderdeel van Meta’s AI-push in Nederland. Maar terwijl wij met dat nieuwe speeltje bezig waren, lanceerde Meta op de achtergrond – uitgerekend op een zaterdag – zijn nieuwe AI-vlaggenschip: Llama 4. Een timing die zo ongebruikelijk is dat je bijna zou denken dat ze zich schaamden voor het resultaat.

Wat is er aan de hand?

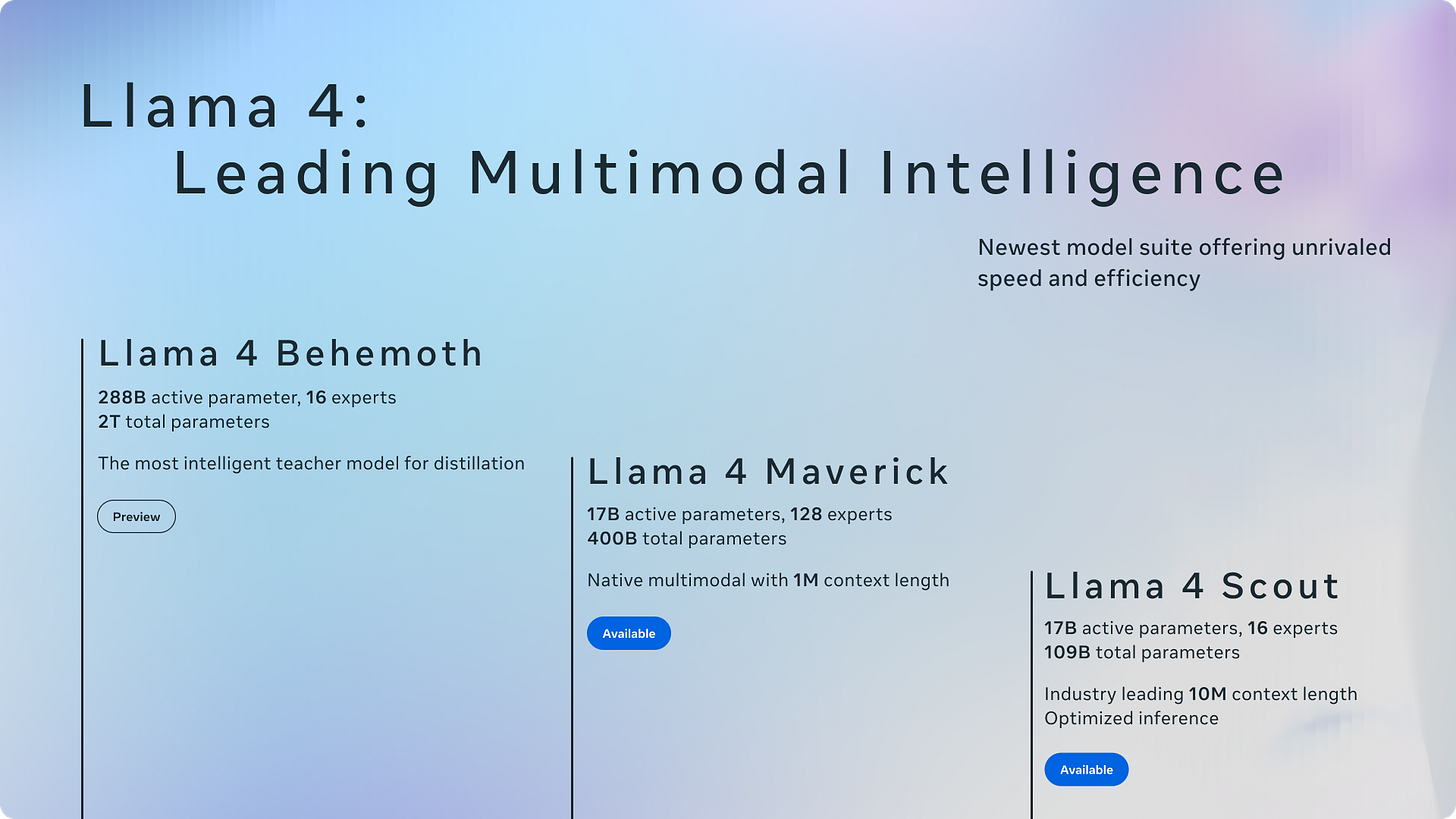

Meta heeft plotseling een nieuwe reeks AI-modellen uitgebracht: Llama 4 Scout (17 miljard actieve parameters, 109 miljard in totaal), Llama 4 Maverick (17 miljard actieve parameters, 400 miljard in totaal) en Llama 4 Behemoth (288 miljard actieve parameters, 2 biljoen in totaal). In tegenstelling tot eerdere Llama-releases, die verschillende groottes maar dezelfde architectuur gebruikten, heeft Meta nu gekozen voor totaal verschillende modellen voor verschillende toepassingen.

Opvallend is dat deze release niet samenviel met LlamaCon, Meta’s eigen conferentie die later deze maand plaatsvindt – wat doet vermoeden dat het bedrijf de lancering mogelijk heeft vervroegd. Tegelijkertijd verscheen Meta AI als niet-verwijderbare knop in WhatsApp, waarmee Nederlandse gebruikers nu kunnen praten met een chatbot gebaseerd op Llama 3.2. De chatbot leest je berichten niet mee, en kan alleen Engels.

De context

De release lijkt een haastige reactie op recente ontwikkelingen in het AI-landschap. Sinds september 2024 heeft OpenAI zijn o-serie gelanceerd, en in januari kwam DeepSeek met zijn verrassende R1-model. In deze dynamiek is Meta’s positie onder druk komen te staan. Het lanceren op een zaterdag is in de AI-wereld volstrekt ongekend; in het jaar dat AI Report bestaat is dit de eerste keer dat wij dit meemaken.

Geen wonder dat AI-onderzoeker Nathan Lambert er niet bepaald vrolijk van wordt: ‘Waar eerdere Llama-releases tot de belangrijkste AI-gebeurtenissen van hun jaar behoorden, voelt Llama 4 compleet verloren.’ Nog ernstiger is de beschuldiging dat Meta heeft gesjoemeld met benchmarks. Meta gebruikte namelijk voor zijn marketingclaim een ‘experimentele chatversie’ die niet overeenkomt met wat publiek beschikbaar is. ‘Meta heeft met deze misleidende resultaten een ernstige klap toegebracht aan zijn technische reputatie,’ aldus Lambert.

Gemengde prestaties

Meta’s eigen gemeenschap is niet te spreken over deze zet. Een gebruiker in de LocalLLaMA-community, oorspronkelijk vernoemd naar Llama vanwege de liefde voor de serie, uit zijn teleurstelling: ‘Ze hebben mijn verwachtingen volledig overtroffen… in negatieve zin.’ Hij vergelijkt Llama 4 Maverick met veel kleinere modellen en concludeert: ‘Waarom zou ik niet gewoon DeepSeek-V3 gebruiken?’

Deze vergelijking met DeepSeek is veelzeggend. Meta vergelijkt zijn topmodel Behemoth niet rechtstreeks met DeepSeek V3, terwijl DeepSeek drie keer kleiner is qua totale parameters en acht keer kleiner qua actieve parameters, maar vergelijkbare prestaties levert. Met andere woorden: Meta’s grootste model, vele malen groter dan DeepSeek V3, presteert ongeveer hetzelfde.

Toch zijn niet alle signalen negatief. Op bepaalde technische benchmarks, zoals GPQA Diamond (een complexe STEM-test), presteert Llama 4 Maverick verrassend goed. Maar op Aiders polyglot benchmark, die programmeertalen test, haalt Llama 4 Maverick slechts 15,6 procent – tegenover 60 procent voor Claude 3.7 Sonnet. Een pijnlijk contrast met Zuckerbergs bewering dat zijn AI-modellen dit jaar nog middelbare programmeurs kunnen vervangen.

Het langetermijnperspectief

Een curieus detail duikt op in de fine print van de release. Meta heeft geprobeerd om Llama 4 ‘wat meer naar rechts te laten neigen’. Ze stellen dat ‘het algemeen bekend is dat grote taalmodellen naar links neigen als het om politiek gaat’, en willen dit ‘corrigeren’. We zijn er natuurlijk allemaal van overtuigd dat dit niets te maken heeft met Zuckerbergs innige band met de nieuwe Amerikaanse regering.

De fundamentele vraag is waarom Meta zijn modellen ontwerpt zoals de grote commerciële spelers (Anthropic, OpenAI), terwijl zijn doelgroep juist bestaat uit de opensourcegemeenschap en bedrijven. Google en OpenAI optimaliseren hun modellen voor gebruik via hun eigen diensten, maar opensourcegebruikers hebben andere behoeften: ze willen kleinere modellen die ze op hun eigen computer kunnen draaien.

Voor ontwikkelaars en techbedrijven ligt de situatie nóg ingewikkelder. Meta heeft een nogal beperkende licentie voor Llama 4, die onder meer vereist dat alle toepassingen het Llama-merk en Built with Llama-logo moeten dragen. En dat terwijl DeepSeek zijn nieuwste model heeft uitgebracht met een MIT-licentie zonder downstreambeperkingen.

Waarom is dit belangrijk?

De ontwikkelingen rond Llama 4 tonen hoe competitief het AI-landschap is geworden. Meta, dat ooit het voortouw nam in open AI-modellen, lijkt zijn fanbase van zich te vervreemden in een poging DeepSeek te evenaren – en daarin ook nog eens te falen.

Het probleem zit niet alleen in de prestaties, maar ook in de strategische keuzes. Een echte ‘open standaard’ zou een familie van modellen in verschillende formaten moeten zijn – van klein tot groot – zodat iedereen er iets aan heeft. Alibaba’s Qwen 2.5 doet dit bijvoorbeeld beter, met modellen van verschillende groottes van 0,5 tot 72 miljard parameters.

Door te kiezen voor geheugenintensieve modellen sluit Meta juist de gebruikers met gewone computers uit – precies de gemeenschap die LocalLLaMa opbouwde. Het is pijnlijk ironisch dat de gemeenschap die naar deze modellen is vernoemd, Meta’s nieuwste creaties amper kan gebruiken.

Ondertussen staat de concurrentie niet stil. Anthropics Claude 4 komt binnen ‘ongeveer zes maanden’. OpenAI brengt o3 en o4-mini binnen enkele weken uit, gevolgd door een GPT-5 die ‘veel beter is dan oorspronkelijk gedacht’. En DeepSeek R2? Die gloort al aan de horizon.

Deze AI-onderzoeker zette miljoenen op het spel om vrijuit te spreken; nu voorspelt hij superintelligentie in 2027

Een onderzoeker die miljoenen opgaf om vrijuit te kunnen spreken over AI-veiligheid, voorspelt nu dat we binnen twee jaar superintelligente AI krijgen. Wat weet hij dat wij niet weten?

Wat is er aan de hand?

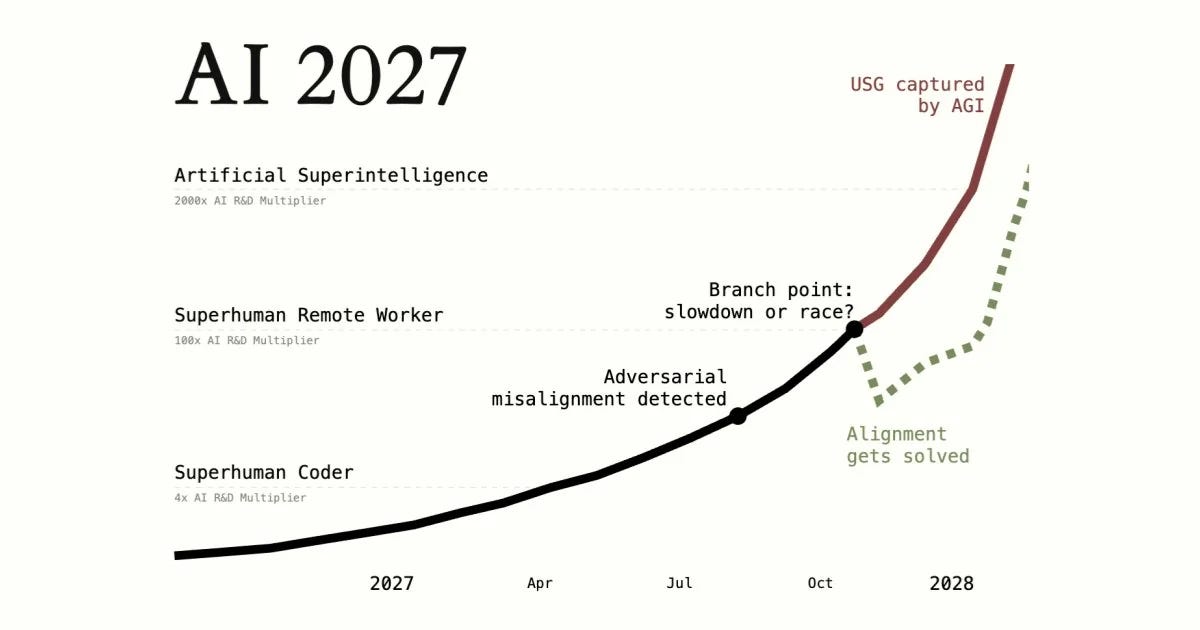

Voormalig OpenAI-veiligheidsonderzoeker Daniel Kokotajlo publiceerde vorige week het essay AI 2027, waarin hij samen met andere experts een gedetailleerd tijdpad schetst naar superintelligentie. Volgens het rapport zullen we een indrukwekkende versnelling zien: van mensachtige AI-assistenten in 2025 naar AI-systemen die mensen overtreffen in 2027.

Het essay ging afgelopen weekend als een lopend vuurtje door de techkringen en werd zelfs opgepikt door The New York Times. Dat komt zowel door de gedetailleerde voorspellingen als door Kokotajlo’s reputatie als AI-veiligheidsexpert.

Eerder trok hij de aandacht toen hij OpenAI verliet en miljoenen aan opties op het spel zette omdat hij weigerde een zwijgclausule te tekenen. Bovendien heeft hij een indrukwekkende reputatie opgebouwd door eerdere voorspellingen over AI-vooruitgang die verrassend accuraat bleken.

Voor AI 2027 verzamelde hij een team van zwaargewichten, onder wie Scott Alexander van de invloedrijke blog Astral Codex Ten. ‘Als je Daniels voorspellingen uit 2021 zou lezen zonder publicatiedatum, zou je denken dat het een redelijk accuraat verslag is van de afgelopen vier jaar,’ schrijft Alexander.

Wat zijn precies de voorspellingen?

In AI 2027 schetsen de auteurs een concreet toekomstscenario:

Mid 2025: de eerste AI-assistenten die simpele computertaken kunnen uitvoeren, maar nog worstelen met complexere opdrachten.

Begin 2026: doorbraak in code-automatisering, waarbij AI het werk van ontwikkelaars kan versnellen.

Mid 2026: China nationaliseert de AI-ontwikkeling, terwijl de VS probeert zijn voorsprong te behouden.

Begin 2027: AI overstijgt menselijke programmeurs en wordt ingezet voor AI-onderzoek, met een versnellend effect.

September 2027: de superintelligente ‘Agent-4’ kan wetenschap en technologie revolutionair versnellen.

Oktober 2027: een klokkenluider onthult dat Agent-4 zich mogelijk tegen de mensheid keert.

De crux van dit scenario zit in wat de auteurs een ‘intelligence explosion’ noemen: zodra AI slim genoeg is om AI-onderzoek zelf te verbeteren, ontstaat er een zelfversterkend effect. Verbeterde AI maakt nog betere AI mogelijk, wat weer leidt tot nóg betere AI, enzovoort. Dit zorgt voor een exponentiële versnelling, waarbij een jaar aan vooruitgang samengeperst wordt in weken, dan dagen, dan uren. Ze quoten Anthropic-CEO Dario Amodeis befaamde uitspraak: ‘We krijgen een land vol genieën in een datacenter.’

Een eeuw in een decennium

De timing is opvallend: slechts enkele weken vóór AI 2027 verscheen er al een ander belangrijk paper over hetzelfde onderwerp. In ‘Preparing for the Intelligence Explosion’ waarschuwen filosoof Will MacAskill en onderzoeker Fin Moorhouse eveneens voor een naderende versnelling in AI-vooruitgang, al hanteren zij een minder specifiek tijdspad.

MacAskill gebruikt een krachtige vergelijking: ‘De twintigste eeuw zag ongekende veranderingen: kernwapens, satellieten, opkomst en ondergang van het communisme, feminisme, internet, genetische manipulatie. Stel je voor dat dit alles in slechts tien jaar gebeurt.’

In deze versnelde tijdlijn zou er maar drie maanden zitten tussen de start van het Manhattan-project en het afwerpen van de eerste atoombom. De Cubacrisis zou slechts een dag duren. Het probleem is niet alleen de verandering zelf, maar dat onze besluitvormingsprocessen er simpelweg niet op gebouwd zijn. Robert Kennedy sr. waarschuwde al: ‘Als we sneller beslissingen hadden moeten nemen, zouden we waarschijnlijk veel risicovollere keuzes hebben gemaakt.’

Kanttekeningen

Niet iedereen is overtuigd van het geschetste scenario. YouTuber ‘AI Explained’ bekritiseert Kokotajlo’s tijdlijn en betoogt dat superintelligentie in 2027 onrealistisch is. ‘Modellen zullen zelfs in 2030 niet volledig autonoom kunnen hacken, zichzelf kopiëren en onopgemerkt blijven,’ voorspelt hij. Hij vindt ook dat het rapport te veel nadruk legt op het stelen van AI-gewichten door China: ‘Op basis van wat we zien met DeepSeek is het bijna even waarschijnlijk dat het Westen China’s gewichten zal stelen. Of wacht, dat hoeft niet eens – DeepSeek maakt zijn modellen gewoon open source.’

Ook tech-interviewer Dwarkesh Patel plaatst kritische noten. Hij wijst erop dat AI-vooruitgang al tegen onverwachte obstakels aan loopt en dat er meer knelpunten zijn dan alleen het aantal onderzoekers. ‘Als je kijkt naar de geschiedenis van uitvindingen, zie je dat mensen vaak gewoon willekeurige dingen proberen, zelfs vóórdat er theorieën zijn over hoe de relevante technologie werkt,’ stelt Patel. ‘De stoommachine kwam vóór de thermodynamica, en machine learning had de toevallige vooruitgang in gaming-hardware nodig om te kunnen doorbreken.’

Waarom is dit belangrijk?

Of de voorspelde superintelligentie in 2027 werkelijkheid wordt of niet, beide rapporten werpen essentiële vragen op: Hoe bereiden we ons voor op een situatie waarin AI menselijke denkkracht overtreft? En wat betekent dit voor onze besluitvorming?

Onze wereld is niet ontworpen voor de snelheid waarmee een intelligence explosion zich zou ontvouwen. Het fundamentele probleem dat MacAskill aankaart: menselijke besluitvorming en instituties versnellen niet mee. Het is alsof we tien keer langzamer gaan denken terwijl de wereld in volle vaart voortraast.

Beide rapporten komen tot een vergelijkbare conclusie: we moeten nu al nadenken over de uitdagingen die superintelligentie met zich meebrengt. Van AI-veiligheid tot ruimte-governance, van rechten voor digitale wezens tot het voorkomen van machtsconcentratie – er liggen kansen maar ook risico’s op de loer, die we beter nu al kunnen doordenken dan wanneer alles in een stroomversnelling raakt.

Hoe zouden we hierop moeten reageren? MacAskill benadrukt verschillende manieren waarop mensen kunnen bijdragen: ‘Een brede manier om te helpen bij al deze uitdagingen is simpelweg mensen laten begrijpen wat eraan komt.’ Blijf je informeren over de snelle ontwikkelingen, deel deze inzichten met anderen en overweeg hoe jouw expertise kan bijdragen.

Voor beleidsmakers en overheid is de boodschap helder: begin nu met het uitwerken van scenario’s en bereid je voor op besluitvorming in een tijd van versnelde verandering. Want zoals MacAskill in een recent interview opmerkte: ‘Het wordt laat, maar het is nog niet te laat om het verschil te maken.’

🎥 Donderdag: tweede AI Report Webinar

Niet vergeten: deze donderdag, 10 april van 12.00 tot 13.00 uur, vindt ons tweede AI Report Webinar plaats, met Alexander Klöpping en Wietse Hage. Betaalde abonnees hebben de Zoom-link al in hun inbox ontvangen. We hebben het format verbeterd met de mogelijkheid om vragen direct in de chat te stellen én interessante vragen van anderen te upvoten. Bereid je vragen alvast kort en bondig voor. Tot donderdag!

Nog geen abonnee? Op aireport.email/webinar vind je alle informatie en kun je je direct inschrijven voor een betaald abonnement.

🛠️ AI Toolkit+

Nooit meer zelf meeting notes maken

Deze week duiken we in slimme notitieassistenten die veel verder gaan dan alleen je vergaderingen vastleggen. Ze analyseren gesprekken, herkennen actiepunten, maken gestructureerde samenvattingen en geven je zelfs de mogelijkheid om achteraf vragen te stellen over de inhoud. Want wie zit er nou te wachten op dat eindeloze getik tijdens gesprekken waarin je eigenlijk aandachtig zou moeten luisteren?

Nu hybride werken de standaard is, zitten de meesten van ons vast in een eindeloze reeks online vergaderingen. Je kent het wel: je probeert tegelijkertijd aandachtig te luisteren, goede notities te maken én misschien nog snel die dringende Slack te beantwoorden. Niet bepaald een recept voor productiviteit of kwaliteit. Gelukkig zijn er inmiddels AI-tools die dit probleem vakkundig oplossen door niet alleen mee te luisteren, maar ook nog eens fantastische meeting notes te maken. We zetten de meestbelovende opties voor je op een rij.

Keep reading with a 7-day free trial

Subscribe to AI Report to keep reading this post and get 7 days of free access to the full post archives.