Is Elon Musks AI de slimste ter wereld?

PLUS: voormalig OpenAI-topvrouw begint nieuw lab, en waarom ‘alsjeblieft’ zeggen tegen AI geen tijdverspilling is

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

🗞️ Het belangrijkste nieuws

Elon Musks nieuwste AI is de slimste ter wereld (maar voor hoelang?)

Elon Musk noemt zijn nieuwste AI-model ‘de slimste ter wereld’. En voor één keer is dat geen grootspraak – althans, als we kijken naar publiekelijk beschikbare modellen. Grok 3, ontwikkeld door Musks AI-bedrijf xAI, presteert op verschillende belangrijke tests beter dan concurrenten als GPT-4o en Claude. Maar met nieuwe versies van OpenAI en Anthropic in aantocht rijst de vraag: hoelang kan Musk deze titel vasthouden?

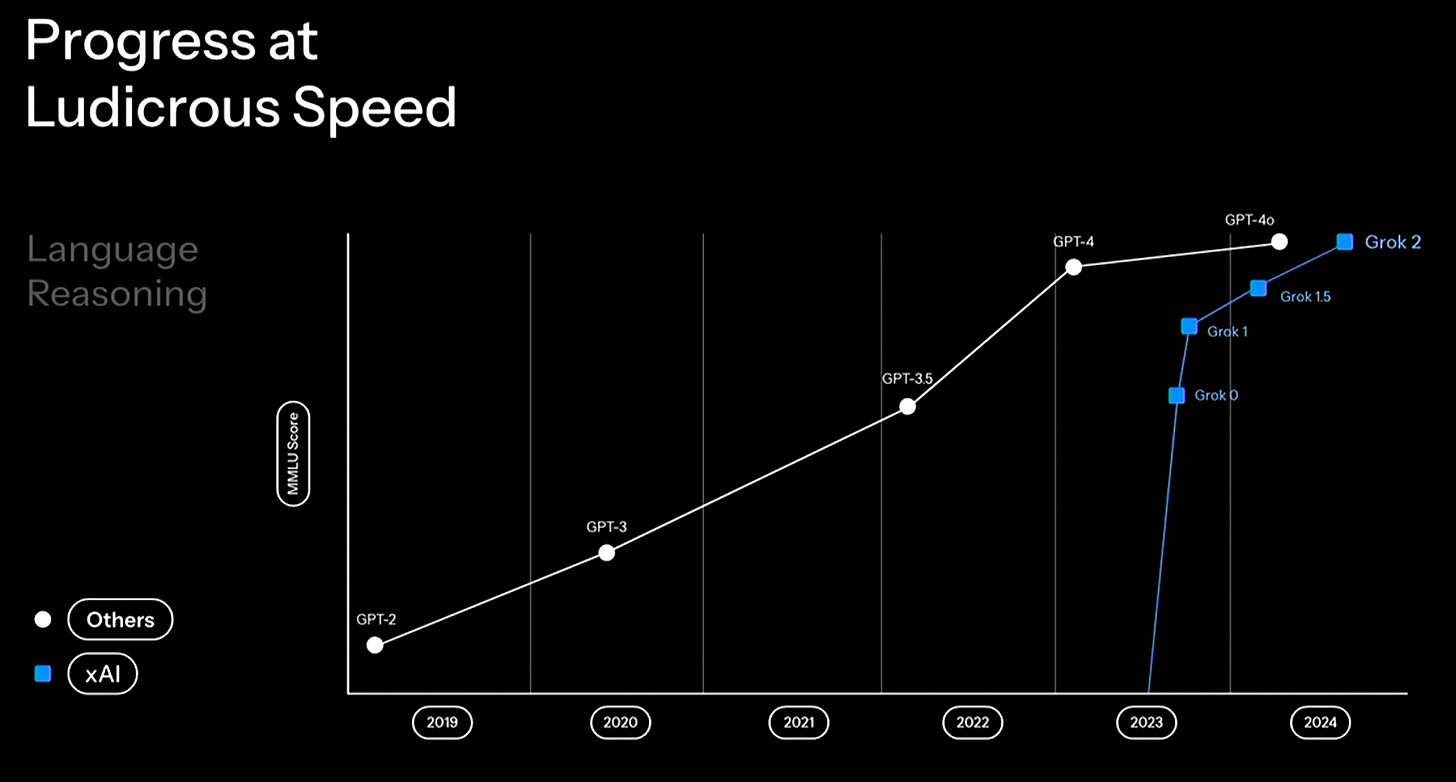

Een bliksemsnelle inhaalrace

Het is een prestatie van formaat: in nog geen twee jaar tijd heeft xAI de gevestigde orde ingehaald. De eerste praktijktests zijn indrukwekkend. ‘Grok 3 zit qua capaciteiten ongeveer op het niveau van OpenAI’s sterkste modellen zoals o1-pro, en presteert beter dan DeepSeek R1 en Gemini 2.0,’ zegt Andrej Karpathy, een gerespecteerde stem in de AI-wereld. ‘Best ongelooflijk als je bedenkt dat het team pas een jaar geleden vanaf nul begon.’

Die snelle opmars heeft grote gevolgen voor de concurrentie. OpenAI, Anthropic en Google kunnen het zich niet langer veroorloven maandenlang aan hun modellen te schaven. Ze hebben nog steeds een voorsprong, maar die wordt met de dag kleiner.

De getallen achter het succes

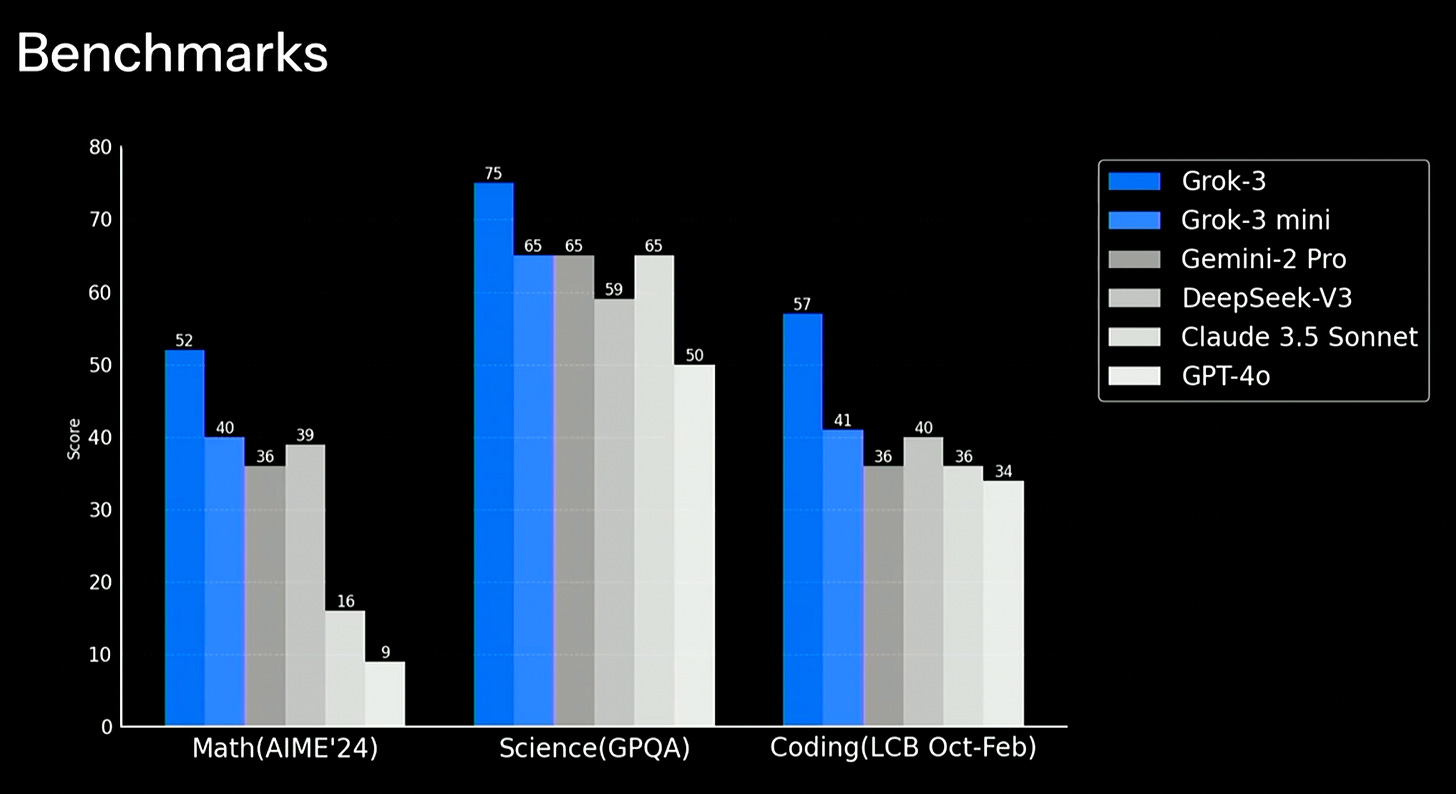

De kracht van Grok 3 komt niet uit het niets. xAI zette voor de training het Colossus-supercomputercluster in, uitgerust met 200.000 krachtige H100-chips, een absurd aantal. Het model presteert sterk op belangrijke tests:

toppositie op ChatBot Arena, waar gebruikers AI-modellen direct kunnen vergelijken;

beste scores op AIME 2024, GPQA en LiveCodeBench, belangrijke maatstaven voor wiskundige en programmeercapaciteiten;

prestaties vergelijkbaar met de duurste abonnementsmodellen van concurrenten (zoals OpenAI’s o1-pro van 200 dollar per maand).

De ‘bitter lesson’ bevestigd

Alberto Romero, AI-onderzoeker, ziet in DeepSeek en xAI twee tegengestelde benaderingen van hetzelfde probleem. ‘DeepSeek moest noodgedwongen innoveren vanwege beperkte middelen, terwijl xAI simpelweg meer chips kon inzetten. Beide deden het geweldig met wat ze hadden. Maar xAI staat er beter voor en dat zal de komende maanden alleen maar duidelijker worden.’ De resultaten bevestigen wat AI-pionier Richard Sutton de ‘bitter lesson’ noemt: pure rekenkracht wint het uiteindelijk van slimme programmeertrucs.

Professor en auteur van ons boek Co-intelligentie Ethan Mollick vult aan: ‘Grok 3 kwam precies uit waar we het verwachtten. Het bevestigt wat we al dachten: de ontwikkeling versnelt, snelheid is cruciaal, rekenkracht blijft belangrijk en er is geen geheime formule voor het maken van een topmodel als je genoeg talent en chips hebt.’

Kanttekeningen bij het succes

Toch zijn er redenen voor scepsis. XAI publiceerde opvallend weinig testresultaten – slechts vier in totaal, waar concurrenten er vaak tien tot twintig delen. Het is dus zeer waarschijnlijk dat Grok 3 niet in alle categorieën het beste presteert. Ook belangrijk: een OpenAI-medewerker bevestigde dat hun krachtigste redeneermodel, o3, nog steeds met kop en schouders boven Grok 3 uitsteekt, maar omdat dit model niet publiekelijk beschikbaar is, is het eerlijk dat xAI dit niet heeft meegenomen in de vergelijkingen.

De prestaties op ChatBot Arena zijn indrukwekkend, al zijn er kanttekeningen. Het platform bevoordeelt modellen die minder vaak verzoeken weigeren, wat verklaart waarom het veiligheidsbewuste Claude 3.5 Sonnet relatief laag scoort. Toch is het geen geringe prestatie om bovenaan te eindigen.

Van voorvechter naar aanjager

Het opvallendste aspect van Grok 3’s lancering is misschien wel de ommezwaai die ze vertegenwoordigt in Musks houding tegenover AI-veiligheid. Jarenlang waarschuwde hij voor de gevaren van ongecontroleerde AI-ontwikkeling. Hij verbrak zelfs zijn vriendschap met Google-oprichter Larry Page na een verhit diner in 2015, waar ze botsten over AI-veiligheid. Waar Page AI zag als de volgende stap in de evolutie, bleef Musk hameren op het behoud van menselijke intelligentie.

Die Musk lijkt verdwenen. Nathan Lambert, AI-onderzoeker, vraagt zich af: ‘Hoeveel prestatiewinst behaal je door veiligheid minder prioriteit te geven?’ In de presentatie van Grok 3 staat opvallend weinig over veiligheidsmaatregelen.

Deze ontwikkeling baart ook onze Wietse zorgen: ‘We hebben een geopolitieke situatie waarin Elon Musk een gigantische rol speelt. In mijn ogen een gevaarlijke, spannende en ingewikkelde situatie,’ zegt hij. ‘Het is een man die denkt dat je een land moet runnen als een bedrijf, waarin je mensen kunt ontslaan en alles wat in de weg zit, alle bureaucratie, moet verwijderen. Als dat gebeurt bij je lokale kruidenier is dat al spannend, maar als dat gebeurt in Amerika als land, dan heeft het gewoon gigantische gevolgen.’

Extra zorgwekkend is de ongekende machtsconcentratie. Musk is niet alleen CEO van xAI, maar ook van X, SpaceX, Tesla, Neuralink en diverse andere bedrijven. Tel daarbij zijn rol als adviseur bij de Amerikaanse overheid op. Waar sommigen hoopten dat zijn positie bij het Department of Government Efficiency zou leiden tot meer aandacht voor AI-veiligheid, lijkt het tegenovergestelde waar. Er zijn zelfs berichten dat DOGE gevoelige overheidsinformatie door AI-modellen laat analyseren.

‘Alle macht naar één plek, naar iemand met zo’n visie op bestuur – daar word ik wel zenuwachtig van,’ vervolgt Wietse. ‘Het feit dat AI daar nu ook een rol in speelt is onvermijdelijk, maar wel zorgelijk. We kunnen het technische nieuws over Grok 3 niet los zien van deze bredere context.’

De prijs van snelheid

Nathan Lambert ziet een zorgwekkende trend. ‘De concurrentiedruk van DeepSeek en Grok, gecombineerd met een veranderend politiek klimaat, dwingt de gevestigde laboratoria sneller te lanceren. Een groot deel van de vertragingen kwam door veiligheidstests, maar we weten niet precies hoeveel daarvan echt noodzakelijk was en hoeveel te maken had met risicoafwegingen en juridische overwegingen.’

Lambert signaleert dat veiligheid steeds minder prioriteit krijgt in het AI-debat. ‘Dit werd pijnlijk duidelijk tijdens J.D. Vance’ toespraak op de AI Action Summit. Deze overcorrectie kan betekenisvolle schade veroorzaken. We hebben het over een extreem krachtige technologie die zich razendsnel ontwikkelt.’

‘Het merk en de cultuur van “het slimste model hebben” zijn extreem belangrijk voor deze bedrijven,’ vervolgt Lambert. ‘Maar een véél slimmer model bouwen was vaak financieel niet haalbaar. Nu, met toenemende concurrentie en afnemende regulering, krijgen wij als gebruikers waarschijnlijk veel krachtigere AI in een veel hoger tempo.’

Met de aangekondigde releases van GPT-4.5/5 en een nieuwe versie van Claude wordt het een spannend jaar. Veiligheid is niet langer een prioriteit. De politieke druk neemt toe en de concurrentie is moordender dan ooit. De grote vraag is niet alleen wie de slimste AI kan bouwen, maar ook: tegen welke prijs?

Voormalig OpenAI-topvrouw start AI-lab met menselijke maat

Terwijl veel AI-bedrijven zich blindstaren op het ontwikkelen van superintelligente systemen, kiest Mira Murati een verfrissend andere koers. De voormalige technisch directeur van OpenAI presenteerde dinsdag haar nieuwe bedrijf Thinking Machines Lab, dat zich richt op het verbeteren van de samenwerking tussen mens en AI. Een belangrijk signaal in een tijd waarin steeds meer techbedrijven elkaar verdringen in de race naar superintelligentie.

Wat is er aan de hand?

Murati verzamelde een indrukwekkend team van dertig experts om zich heen, onder wie verschillende oud-collega’s van OpenAI. Opvallende namen zijn John Schulman als wetenschappelijk directeur, die eerder deze maand vertrok bij Anthropic, en Barret Zoph als technisch directeur. Het team heeft zijn sporen verdiend met projecten als ChatGPT, character.ai en populaire opensourcetools als PyTorch.

De OpenAI-diaspora

Het vertrek van Murati past in een opvallende trend: steeds meer OpenAI-kopstukken beginnen voor zichzelf. Zo richtte Dario Amodei het inmiddels beroemde Anthropic op, en werkt Ilya Sutskever aan Safe Superintelligence (SSI) – een start-up die volgens Bloomberg afstevent op een waardering van 30 miljard dollar.

Een andere kijk op AI

Waar veel AI-labs zich richten op autonome systemen die mensen moeten overtreffen, kiest Thinking Machines Lab een andere aanpak. ‘In plaats van ons alleen te richten op volledig zelfstandige AI-systemen, bouwen we multimodale systemen die met mensen samenwerken,’ licht het bedrijf toe in zijn aankondiging. Het doel: AI toegankelijk maken voor iedereen, niet alleen voor de usual suspects – de programmeurs, wiskundigen en AI-enthousiastelingen die hun prompts tot in de puntjes kunnen verfijnen.

Deze aanpak komt niet uit de lucht vallen. Een van de grootste uitdagingen in de AI-wereld is het zogenaamde last mile problem: AI-systemen worden steeds slimmer, maar struikelen vaak op het laatste stukje – de daadwerkelijke samenwerking met mensen. Denk aan een chatbot die in theorie briljante code kan schrijven, maar niet begrijpt wat je écht nodig hebt. Het is als een Intercity direct die razendsnel door het land rijdt, maar op het laatste stukje naar je eindbestemming vastloopt.

Dit probleem wordt steeds urgenter naarmate AI-systemen krachtiger worden. Natuurlijk zijn er voor de doorgewinterde gebruiker allerlei manieren om AI beter te laten doen wat je wilt – de kunst van prompt engineering bespreken we niet voor niets wekelijks in AI Report. Maar voor brede adoptie is meer nodig. Je oma zou net zo makkelijk met AI moeten kunnen omgaan als met WhatsApp.

Eerlijkheid als strategie

Thinking Machines Lab kiest nadrukkelijk voor transparantie. Het bedrijf wil regelmatig technische blogposts, papers en code delen. ‘Wetenschappelijke vooruitgang is een gezamenlijke inspanning,’ stelt het bedrijf. ‘Door onze kennis te delen verbeteren we niet alleen het publieke debat, maar ook onze eigen onderzoekscultuur.’

Dit is een opvallende keuze in een tijd waarin veel AI-bedrijven hun technologie angstvallig geheimhouden. Het betekent overigens niet dat alle modellen open source worden – het bedrijf houdt die optie open.

Kanttekeningen

Over concrete producten of een tijdlijn blijft Thinking Machines Lab nog vaag. Ook zijn er geen details bekend over financiering, al zegt het bedrijf er vertrouwen in te hebben voldoende middelen te kunnen aantrekken. Gezien Murati’s staat van dienst en de huidige investeringsbereidheid in AI-bedrijven lijkt dat een realistische inschatting.

Waarom is dit belangrijk?

De lancering van Thinking Machines Lab markeert een stap in het AI-landschap. Waar veel start-ups elkaar verdringen in de race naar superintelligentie, kiest Murati’s team voor een praktischer aanpak.

Deze focus op toegankelijkheid en samenwerking zou weleens cruciaal kunnen zijn voor de brede toepassing van AI in de praktijk. Want wat heb je aan superintelligente systemen als gewone mensen er niet mee kunnen werken?

🔮 Prompt whisperer

Hoe beleefd moet je eigenlijk zijn tegen AI?

Het klinkt misschien als de triviaalste onderzoeksvraag ooit: moet je ‘alsjeblieft’ zeggen tegen een AI? Je hoort sommigen al denken: het is een computer, geen kleuter die we manieren willen bijbrengen. Maar tik een vraag in bij ChatGPT, en je twijfelt misschien toch even. Dat kleine woordje ‘alsjeblieft’ – toevoegen of niet?

Die kwestie houdt niet alleen jou bezig. Wetenschappers hebben er een fascinerend onderzoek aan gewijd, en de resultaten zijn verbluffend: beleefdheid heeft wel degelijk invloed op de kwaliteit van AI-antwoorden. En niet zo’n beetje ook.

De verrassende impact van machine-etiquette

Keep reading with a 7-day free trial

Subscribe to AI Report to keep reading this post and get 7 days of free access to the full post archives.