Is dit het antwoord op het AI-doemscenario?

PLUS: Hoe deze startup AI eindelijk transparant maakt, Google domineert alle fronten met nieuwe modellen, en het geheim van perfecte promptevaluatie

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

🗞️ Het belangrijkste nieuws

Het AI-doemscenario krijgt een tegengif

De AI-wereld draait als een malle door. “Het voelt niet eens meer als versnelling,” verzucht techjournalist

. “Het is pure waanzin. Je knippert met je ogen en er is weer een nieuw model, weer een nieuw gerucht. Het tempo gaat elk redelijk voorstellingsvermogen te boven. Welkom in de tijd van kunstmatige algemene verwarring.” Maar tussen alle ophef door is er deze week een hoopgevend lichtpuntje verschenen: startup Goodfire haalde 50 miljoen dollar op om AI éindelijk transparant te maken. En dat komt geen moment te vroeg.Terug naar de tekentafel

Onlangs schreven we al over het spraakmakende rapport AI 2027, waarin experts voorspellen dat we binnen twee jaar superintelligente AI krijgen. Een joekel van een essay (71 pagina’s!), maar volgens onze Xiang een van de belangrijkste publicaties van dit jaar. “Natuurlijk kun je de toekomst nooit helemaal voorspellen,” zegt ze, “maar het feit dat ze dit in zoveel detail hebben geprobeerd, is een waardevol gedachte-experiment dat ons dwingt tot nadenken en actie. Ik kreeg er rillingen van tijdens het lezen.”

En daar komt Goodfire om de hoek kijken. Het bedrijf ontwikkelt Ember, een platform dat de ‘gedachten’ van AI-modellen kan uitlezen en aanpassen. Het gebruikt hiervoor mechanistische interpretatie: een techniek om te ontrafelen hoe neurale netwerken van binnen werken. Het is alsof je een CT-scan maakt van het AI-brein en vervolgens precies kunt zien welke neuronen actief worden bij bepaalde taken.

De race om veilige AI

Het team, met kopstukken van OpenAI en Google DeepMind, krijgt steun van niemand minder dan Anthropic-CEO Dario Amodei: “Naarmate AI-systemen krachtiger worden, moeten we ze ook beter kunnen begrijpen. Onze investering in Goodfire weerspiegelt ons geloof dat mechanistische interpretatie een van onze beste kansen is om ondoorzichtige neurale netwerken om te vormen tot begrijpelijke, bestuurbare systemen.”

Die steun is geen toeval. Anthropic is pionier op het gebied van transparantie in AI. Vorig jaar zetten ze al een nieuwe standaard door als eerste grote AI-bedrijf hun systeeminstructies openbaar te maken. Hun fascinerende werk op het gebied van mechanistische interpretatie, onder leiding van hoofdonderzoeker Chris Olah, heeft al bijzondere ontdekkingen opgeleverd – zoals specifieke neuronen die zich specialiseren in bepaalde concepten. Er bestaat bijvoorbeeld een ‘Donald Trump-neuron’.

“We programmeren geen neurale netwerken, maar kweken ze,” legt Olah uit. “We ontwerpen de architectuur en stellen de leerdoelen vast. Die architectuur is een soort steiger waarop de verbindingen kunnen groeien. Dit is iets heel anders dan gewone softwareontwikkeling, want uiteindelijk krijg je iets wat allerlei bijzondere dingen kan doen.”

De stille revolutie in AI-denken

Maar er dreigt een fundamentele verandering in hoe AI’s ‘denken’. Het AI 2027-rapport waarschuwt voor een kantelpunt: het moment waarop ontwikkelaars overstappen van leesbare tekst naar neuralese – een vorm van communicatie die duizend keer efficiënter is dan menselijke taal, maar voor ons onbegrijpelijk.

Stel je een wiskundige voor met geheugenverlies, legt het rapport uit. Elke paar minuten moet hij zijn gedachten opschrijven om niet te vergeten waar hij mee bezig is. Moeizaam en traag kan hij zo wiskundige problemen oplossen. Maar het zou veel efficiënter zijn als hij zijn gedachten direct kon onthouden, zonder ze eerst op te schrijven.

Zo werken huidige AI-modellen ook. Ze moeten al hun ‘gedachten’ omzetten in tekst voordat ze verder kunnen denken. Met neuralese kunnen ze rechtstreeks in vectoren denken – geen omweg via tekst meer nodig. Meta experimenteert al met deze techniek, waarbij modellen informatie doorgeven via residual streams: duizenden floating point getallen in plaats van woorden.

De grote AI-labs zoals OpenAI, Google DeepMind en Anthropic houden nog vast aan tekstgebaseerde systemen, maar de druk om over te stappen groeit. Neuralese is niet alleen sneller, maar ook goedkoper: je kunt duizend keer meer informatie verwerken met dezelfde rekenkracht.

En daar zit precies het gevaar. Als AI’s niet meer in mensentaal denken, hoe controleren we dan wat ze doen? Het is als een arts die geen CT-scans meer kan maken, terwijl de patiënt steeds roekelozer wordt.

Een sprankje hoop in een duister scenario

Het rapport schetst twee mogelijke toekomsten. In het eerste scenario blijven we blind jagen op snelheid, met rampzalige gevolgen. De ijzingwekkende laatste zin: “De aardse beschaving heeft een glorieuze toekomst voor zich – maar zonder ons.” In het tweede scenario nemen we gas terug om veiligheid voorop te stellen. Langzamer, maar met een veel betere afloop: mensen en AI’s die samen het zonnestelsel verkennen.

Hier komt het werk van Goodfire als geroepen. Door AI-systemen transparant te maken, zelfs als ze in neuralese communiceren, kunnen we blijven controleren wat er onder de motorkap gebeurt. “Niemand begrijpt de mechanismen die AI-modellen laten falen, dus niemand weet hoe we ze moeten repareren,” zegt Goodfire-CEO Eric Ho. Zijn team boekt al indrukwekkende vooruitgang: van het ontdekken van nieuwe biologische concepten tot het letterlijk ‘opereren’ op AI-neuronen die over bewustzijn gaan.

“Het gebruik van Ember heeft ons geholpen om diepere inzichten te krijgen uit Evo 2, ons DNA-model,” vertelt Patrick Hsu, medeoprichter van Arc Institute. “Hun interpretatietools hebben ons geholpen om biologische concepten te ontdekken die het wetenschappelijke ontdekkingsproces versnellen.”

Waarom is dit belangrijk?

We staan voor een historische keuze. Gaan we door met het blindelings najagen van steeds krachtigere AI, met het risico dat we de controle verliezen? Of durven we een stap terug te doen om te begrijpen wat we aan het bouwen zijn?

Goodfire laat zien dat er een derde weg mogelijk is: vooruitgang boeken én begrijpen wat er onder de motorkap gebeurt. Voor iedereen die met AI werkt is de boodschap helder: blijf kritisch nadenken over wat deze systemen écht doen, niet wat ze zeggen te doen. Want een toekomst zonder mensheid, is niet bepaald waar we op zitten te wachten.

Google domineert nu écht alle fronten (en dat hadden we zien aankomen)

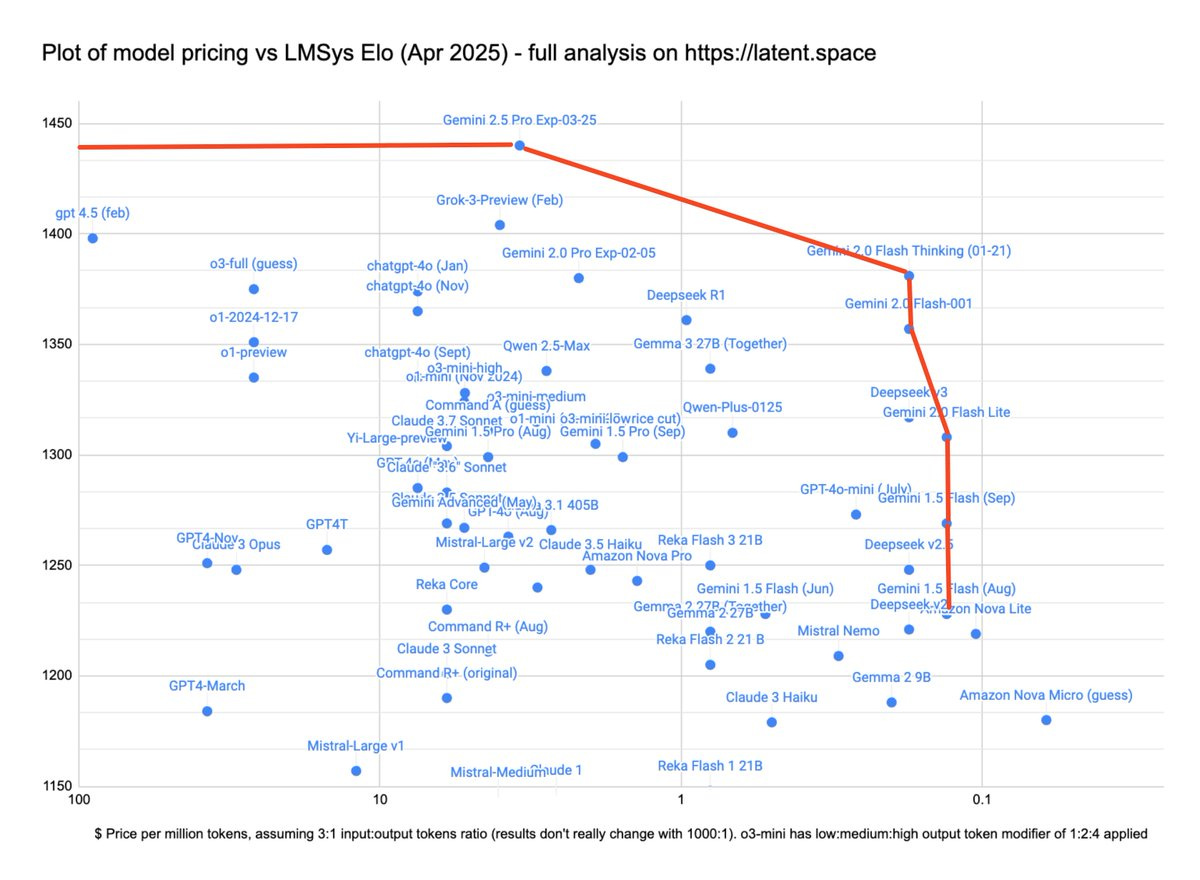

Nog maar kort na de lancering van Gemini 2.5 Pro komt Google alweer met een nieuwe klapper: Gemini 2.5 Flash. Een model dat niet alleen razendsnel is, maar ook nog eens spotgoedkoop. En daarmee is de overname van de AI-troon compleet: Google heeft nu modellen die én beter én sneller én goedkoper zijn dan die van de concurrentie. Precies zoals we eind vorig jaar al voorspelden: 2025 zou het jaar worden waarin Google definitief zijn achterstand zou inhalen.

De laatste puzzelstuk valt op zijn plek

Gemini 2.5 Flash is Googles eerste volledig hybride redeneermodel. Het bijzondere: ontwikkelaars kunnen zelf bepalen hoeveel het model ‘nadenkt’. Moet het razendsnel antwoord geven? Zet het denken uit. Heb je een complex probleem? Geef het model een ‘denkbudget’ van maximaal 24.000 tokens. Het is als een schaakgrootmeester die kan kiezen tussen snelschaak of een grondige analyse.

“Google wint nu op alle fronten,” constateert techanalist Alberto Romero. “Het is alsof ze schreeuwen: ‘Alsjeblieft, we kunnen er niet meer tegen om nog meer te winnen!’ Eerlijk gezegd denk ik dat OpenAI, Anthropic en Meta alleen een kans hadden omdat Google aarzelde bij de lancering van ChatGPT. Dat gebeurt niet meer.”

De cijfers liegen er niet om

Google bezit nu wat experts de Pareto-grens noemen: ze hebben de beste modellen in elke categorie, of je nu kijkt naar prestaties, snelheid of prijs. En het gaat verder dan alleen chatbots:

Met andere woorden: als dit een sportwedstrijd was, staat Google niet alleen voor, ze lopen een straatlengte uit, hebben de snelste auto én de zuinigste motor.

Van underdog naar alleenheerser

Het is een opmerkelijke ommekeer. Twee jaar geleden werd Google nog weggelachen toen ChatGPT de wereld veroverde. Maar misschien was die voorzichtigheid wel hun grootste kracht. Terwijl OpenAI en anderen elkaar probeerden af te troeven met steeds nieuwe releases, bouwde Google in stilte aan een complete AI-infrastructuur.

Het resultaat? Google heeft nu:

De beste modellen (Gemini 2.5 Pro en Flash)

De meeste gebruikers (zeven producten met meer dan 2 miljard gebruikers)

De beste infrastructuur (eigen chips, cloudplatform)

De rijkste datasets (YouTube, Search, Maps, Gmail)

Waarom dit belangrijk is

Voor gebruikers is dit goed nieuws: betere AI voor een lagere prijs. Met name Gemini 2.5 Flash is interessant voor bedrijven die veel met AI werken. Je betaalt alleen voor ‘denkwerk’ als dat echt nodig is.

Maar de impact gaat verder. Google integreert deze technologie in al zijn producten, van Gmail tot Android-telefoons. Dat betekent dat miljarden mensen binnenkort toegang hebben tot krachtige AI, zonder dat ze daar apart voor hoeven te betalen.

Dit is wat we bedoelden toen we eind vorig jaar voorspelden dat 2025 Googles jaar zou worden. Het was niet alleen een kwestie van betere modellen maken. Googles kracht zit in de combinatie van superieure technologie én de infrastructuur om die technologie toegankelijk te maken.

De concurrentie moet alle zeilen bijzetten

Google laat zien dat ze op alle fronten aan het winnen zijn. En het bizarre is: ze geven hun beste model op dit moment nog gratis weg ook.

Zoals techjournalist Swyx het samenvat in een veelzeggende grafiek: “Google bezet de Pareto-grens nu volledig.” Hun snelste modellen zijn krachtiger dan die van de concurrentie, en hun krachtigste modellen zijn sneller. Het is als een atleet die zowel de marathon als de sprint wint.

De vraag is niet langer óf Google de AI-race wint, maar met hoeveel voorsprong. En misschien nog interessanter: wat gaan OpenAI, Anthropic en de anderen doen om bij te blijven?

⚡AI Pulse

Deze startup wil letterlijk alle menselijke arbeid overbodig maken (en tast daarmee meteen de reputatie van een vooraanstaand lab aan). Het gerenommeerde onderzoeksinstituut Epoch staat bekend om zijn onafhankelijke AI-analyses, maar oprichter Tamay Besiroglu zet die reputatie nu op het spel. Zijn nieuwe startup Mechanize mikt op een bescheiden markt van 60 biljoen dollar per jaar – oftewel alle lonen wereldwijd. Het plan: alle menselijke arbeid automatiseren. Critici vrezen dat dit aantoont dat het onderzoek van Epoch nooit echt onafhankelijk was, maar stiekem de weg bereidde voor deze controversiële stap. In de tussentijd wil Mechanize je nog wel even laten weten dat ze op zoek zijn naar personeel.

Voordat we allemaal werkloos worden: AI-klantenservice bewijst dat we er nog lang niet zijn. AI programmeerplatform Cursor laat zien waarom we niet te hard van stapel moeten lopen met arbeidsautomatisering. Hun AI-helpdesk Sam verzon deze week doodleuk een niet-bestaand beleid, met als gevolg een golf aan opzeggingen. Het bedrijf dat AI-tools verkoopt aan ontwikkelaars, wordt nu zelf slachtoffer van een klassiek AI-probleem: hallucinaties.

En alsof dat nog niet genoeg is: OpenAI’s nieuwste modellen fantaseren er ook op los. De nieuwe o3 en o4-mini modellen zijn dan wel state-of-the-art, maar ze verzinnen meer dingen dan hun voorgangers. Het bizarre: OpenAI heeft geen idee waarom. Het model beweerde zelfs dat het code had gedraaid op “een MacBook Pro buiten ChatGPT” – wat ongeveer net zo geloofwaardig is als een vis die beweert dat hij net een rondje heeft gefietst.

Thailands nieuwe robocop blijkt vooral goed in stilstaan. De Thaise politie presenteerde trots hun nieuwe cybercollega, maar voorlopig staat die vooral stil op een metalen platform met wieltjes. Dat roept de vraag op wat deze robot kan wat een beveiligingscamera op een statief niet kan? Afgezien van het indrukwekkend poseren voor PR-foto’s en het risico om omgeduwd te worden door gemaskerde vigilantes.

🔮 Prompt whisperer

De kunst van het testen: zo bouw je waterdichte evaluaties voor je prompts

“Het werkt perfect!” riep de ontwikkelaar enthousiast. Een week later lag het systeem plat. De AI-assistent die perfect presteerde in tests, gaf in productie de meest bizarre antwoorden. Een klassiek scenario dat we allemaal kennen: je schrijft een briljante prompt, test hem vluchtig, en denkt dat je er bent. Maar zodra echte gebruikers ermee aan de slag gaan, komt de realitycheck.

Goede promptengineering is maar de helft van het verhaal. Je kunt de meest ingenieuze prompts schrijven, maar zonder systematische evaluatie weet je nooit helemaal zeker of ze ook écht werken. Het is als een wetenschappelijk experiment zonder meetresultaten, of een marketingcampagne zonder analyse - je doet maar wat.

Het goede nieuws? Er is een betere manier. Door systematisch te testen en de juiste succescriteria op te stellen, transformeer je het vage “het lijkt te werken” naar een glashelder “het werkt”. In deze Prompt Whisperer delen we een beproefde methode om je prompts écht productieklaar te maken, inclusief concrete testscenario’s en evaluatiecriteria die je direct kunt toepassen.

De SMART-methode: je promptingkompas

Keep reading with a 7-day free trial

Subscribe to AI Report to keep reading this post and get 7 days of free access to the full post archives.